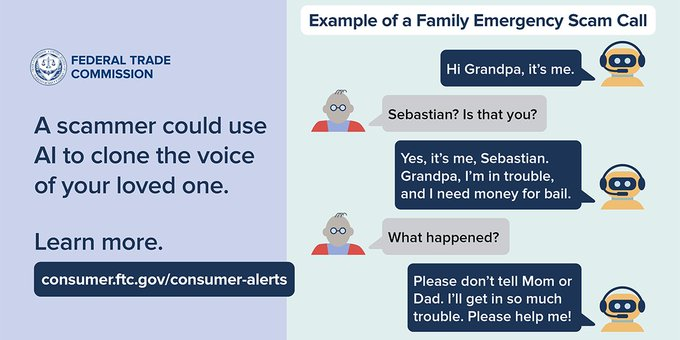

AIを使った「オレオレ詐欺」の可能性は、2023年3月にFTC(アメリカ合衆国連邦取引委員会)から「近い将来可能になるだろう」という注意が提示されていました。

FTCの注意勧告は こちら から(英語サイト)

とうとうやってきた

2026年1月、米国でAIを使って音声を複製し、「オレオレ詐欺」に使うという詐欺が実施されていると発表されたようです。

とうとうやってきた。ということです。

私の認識では「オレオレ詐欺」の方法(テンプレ)は、アジア圏発祥だった記憶なので、今回のもアジア圏でAIで音声を作って米国で試している気がします。

この詐欺のポイント

「オレオレ」という音声ですがこれまでとは違い、あらかじめ本人の声を録音しておき(音声データ)、AIで複製し会話にする(生成AI)ことで、電話に出た相手を信じ込ませるという、20年前だとSFの世界ような方法です。

どうやって声データを取得するのか

詐欺師たちは、狙った相手の息子や娘、親族の携帯電話へ無言電話をします。

無言電話に出た人は「?」となりますので、何かしゃべります。しゃべった音声を録音したら、詐欺師は電話を切ります(録音完了)。

録音できた音声データを生成AIで複製し、会話に使えるレベルへ再現します。で、再現できた「オレオレ」音声を使ってターゲットへ電話。

日本にもやってくるかも?

今は英語圏で発覚しているようですが、いつかは日本にもやってくる方法。

しかし、現実的には日本で普及させるのは難しいと思います。理由は「日本語は複雑」だから。

また、音声データを取得するとしても、無言電話に対して色々と話してもらわなくてはいけませんが、今の日本人、知らない番号からの電話に出ません。出ても英語圏の人のように、気軽に喋りません。

可能性としては「雑な日本語音声」を作って、こもった声に聞こえるフィルターを掛けて「それらしく」して、「風邪ひいてるねん」とか言わせることはできそうですが、英語圏よりも手間がかかることを考えると、それなりに資産を持っている人をターゲットにしないと割に合わないことが予想できます。

さいごに

生成AIの進歩で、こういうことが簡単にできるようになりました。

「だから生成AIは危険!」というつもりはありません。生成AIは道具なので、使い方で良くも悪くもなります。銃やナイフや薬と同じです。使い方次第だし、使う人の気持ち次第。

ただ、どうしてもこういう道具は「悪い方向」へ使われることが多いので、この方法が今すぐ日本にやってこないとしても用心はしておかないといけません。

最終的には「社長の声」を複製して、業務指示に見せかけた「音声」で「企業向けオレオレ詐欺」に使われる可能性だって考えられます。マルウェアを仕込むために、IT担当者のアカウントとパスワードを聞き出すのに使われる可能性だってあります。

日頃から「自分たちは大丈夫」ではなく、注意しておく必要があります。